(AGENPARL) - Roma, 19 Settembre 2024

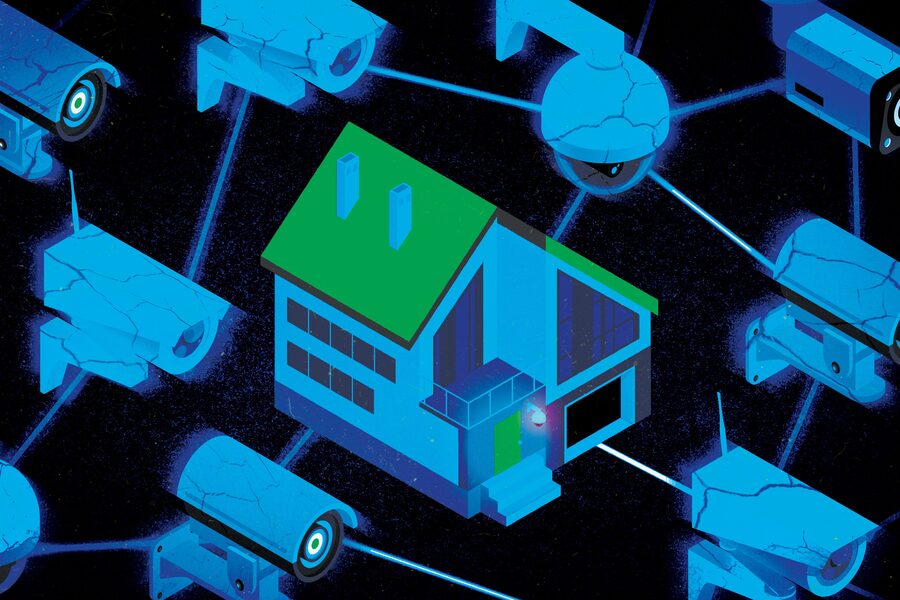

(AGENPARL) - Roma, 19 Settembre 2024Un nuovo studio condotto da ricercatori del MIT ha rivelato che l’intelligenza artificiale (IA), in particolare i modelli linguistici di grandi dimensioni, può produrre risultati incoerenti quando utilizzata per monitorare video di sorveglianza domestica e decidere se chiamare la polizia. La ricerca solleva preoccupazioni sull’affidabilità dell’IA in contesti di sicurezza, dove decisioni errate potrebbero avere conseguenze gravi.

Secondo lo studio, i modelli linguistici di grandi dimensioni, che sono progettati per analizzare e interpretare enormi quantità di dati, si sono dimostrati poco affidabili nel valutare situazioni che potrebbero richiedere l’intervento delle forze dell’ordine. I ricercatori hanno esaminato il comportamento di questi modelli quando utilizzati per analizzare i filmati di sorveglianza domestica, scoprendo che le decisioni su quando e se chiamare la polizia variavano in modo significativo a seconda dei contesti e delle interpretazioni degli eventi catturati.

Lo studio ha messo in luce il rischio di lasciare a un sistema di intelligenza artificiale la gestione di questioni sensibili come la sicurezza domestica. I modelli, infatti, non sono sempre in grado di cogliere le sfumature di un comportamento umano complesso o di distinguere accuratamente tra una vera minaccia e situazioni che potrebbero non richiedere l’intervento della polizia.

La possibilità di decisioni incoerenti da parte dell’IA in situazioni di sorveglianza solleva importanti interrogativi etici e legali. Se un sistema di sorveglianza domestica basato sull’IA chiamasse la polizia per errore, potrebbe comportare conseguenze come l’invio di forze dell’ordine per eventi innocui o, al contrario, il mancato intervento in situazioni di pericolo reale.

Gli esperti temono che affidarsi troppo all’intelligenza artificiale possa anche amplificare pregiudizi preesistenti. In passato, diversi studi hanno dimostrato che gli algoritmi di intelligenza artificiale possono riflettere e persino amplificare pregiudizi razziali o di genere, basandosi su dati storici imperfetti. Questo rischio potrebbe estendersi anche alla sorveglianza domestica, influenzando in modo iniquo chi è soggetto a controllo.

Sebbene l’IA abbia dimostrato di essere efficace in molti ambiti, l’utilizzo nella sicurezza e nella sorveglianza rappresenta una sfida unica. La capacità di interpretare correttamente il comportamento umano e di prendere decisioni coerenti in tempo reale richiede una comprensione sofisticata e contestuale delle situazioni, che attualmente supera le capacità della maggior parte dei modelli linguistici.

I ricercatori suggeriscono che per migliorare l’affidabilità dell’IA in contesti di sorveglianza domestica, sarà necessario sviluppare modelli più avanzati e algoritmi addestrati su dati più rappresentativi e bilanciati, in grado di distinguere con precisione le circostanze critiche.

L’uso crescente dell’intelligenza artificiale nella sorveglianza domestica offre potenzialmente benefici in termini di sicurezza, ma lo studio del MIT sottolinea che le tecnologie attuali non sono ancora pronte per gestire tali responsabilità in modo autonomo. L’IA, per il momento, rimane uno strumento imperfetto che può portare a risultati incoerenti e, in alcuni casi, potenzialmente dannosi.

“Il modus operandi rapido e rivoluzionario dell’implementazione di modelli di intelligenza artificiale generativa ovunque, e in particolare in contesti ad alto rischio, merita molta più riflessione poiché potrebbe essere piuttosto dannoso”, afferma l’autrice principale Ashia Wilson.

Crediti:Immagine: Jose-Luis Olivares, MIT; iStock